最近我发现了一款非常实用的工具——Ollama,它让在本地运行大型语言模型变得超级简单。作为一个科技爱好者,我对这种能在自己电脑上使用AI的想法感到兴奋。安装过程确实有点复杂,但一旦搞定,感觉就像拥有了一个私人AI助手一样方便。

这个软件支持Windows、macOS和Linux系统,兼容性很好。最让我喜欢的是它对数据隐私的保护,毕竟现在谁不担心个人数据被上传到云端呢?而且在没有网络的情况下也能使用,这对经常需要离线工作的我来说简直是神器。

通过Ollama,我可以轻松调用各种强大的模型,比如Llama和DeepSeek的不同版本。虽然配置有点麻烦,但教程写得很清楚,特别是对新手友好的部分让我好感倍增。如果你也想在本地体验AI的力量,这款工具绝对值得一试!

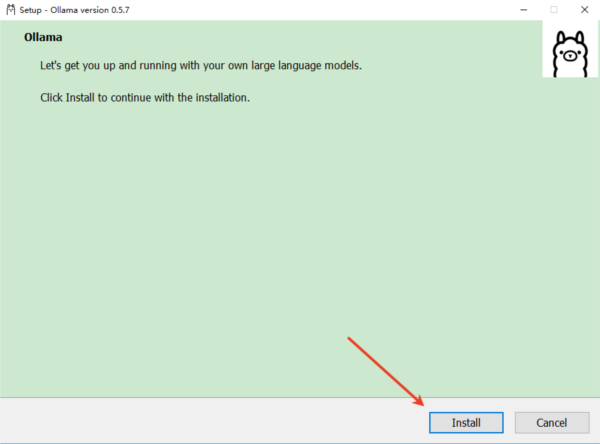

Ollama是一款能让用户在自己的电脑上轻松运行大型语言模型(LLM)的软件,就像是把一个强大的人工智能助手搬到了你的个人设备里。它支持Windows、macOS和Linux系统,安装简单,只需下载并运行对应版本即可开始使用。通过软件,你可以快速获取如Llama、DeepSeek等知名模型,并且无需复杂的配置过程,输入一行命令就能启动模型进行对话或任务处理。这款软件特别适合那些关注数据隐私或者需要在网络不稳定的环境下工作的用户,因为它允许你在本地环境中完全离线地使用这些先进的AI技术。

软件特色

API与多语言支持

RESTAPI:兼容Open AI接口标准,开发者可通过/api/generate和/api/chat接口生成文本或实现对话功能。

客户端集成:支持Python、Java、C#等语言调用,便于与其他应用程序(如Web界面、桌面客户端)集成。

硬件加速与资源优化

GPU加速:在支持CUDA或Metal的设备上,可通过GPU显著提升推理速度。

资源管理:通过环境变量(如OLLAMA_KEEP_ALIVE控制模型内存驻留时间、OLLAMA_MAX_VRAM限制显存占用)优化硬件资源使用。

本地化部署

支持在macOS、Linux和Windows(预览版)系统上运行,无需依赖云端服务。用户可通过Docker容器或直接安装包部署,确保数据隐私与低延迟响应。

模型管理便捷

模型仓库:提供预构建的模型库(如Llama3、Phi3、Gemma2等),用户可通过ollamapull快速下载。

自定义模型:支持通过Modelfile定义模型参数(如温度值、系统提示),并基于现有模型创建个性化版本。例如,可让模型以特定角色(如马里奥)回答问题。

多模型并行:支持同时加载多个模型,并通过调整num_ctx参数控制上下文长度。

本地部署教程

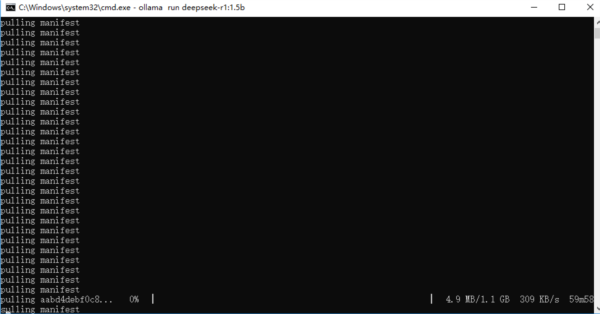

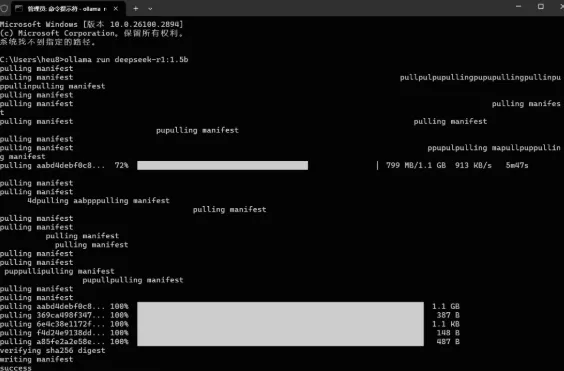

如搭配DeepSeek使用,DeepSeek模型版本有许多:比如1.5b、7b、8b、14b、32b、70b 671b,版本越高越强大,但是对电脑GPU要求也越高。根据你电脑的配置选择合适的版本,每一个版本都对应一个安装命令,把它复制下来。

DeepSeek-R1

ollama run deepseek-r1:671b

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

然后在CMD命令框,输入上述命令。例如:ollama run deepseek-r1:1.5b,便可以自动在线部署安装。

部署成功后,我们可以使用命令窗口直接输入你想问的问题。

本地部署需要什么配置

硬件要求

内存:最低8GB内存,推荐16GB或更高

显卡:支持NVIDIA和AMD显卡,建议使用至少8GB显存的显卡,如NVIDIA的30、40系列或AMD的T4、V100、A10等系列

处理器:最低8核处理器,推荐16核或更高

存储:至少100GB的存储空间

软件依赖

Docker:某些功能可能需要Docker支持

Python:用于高级功能开发

共有 0条评论